Die Ars Electronica hat den Menschheitstraum, Dinge durch die Kraft der Gedanken oder Blicken zu bewegen, in einem Projekt umgesetzt, das die Besucher des Ars Electronica Festivals nicht nur bestaunen dürfen. Sie selbst sind aufgefordert einen Schaufelbagger durch Augenbewegung oder Gehirnpower zu kontrollieren.

Eine Bewegung oder Ortsveränderung von Gegenständen durch geistige Kräfte ist ein Phänomen, das dem Reich der Parapsychologie entspringt. Die so genannte Telekinese spiegelt eine Faszination wider, die von Menschen mit spiritistischen Fähigkeiten ausgeht. Dabei sind ihre übernatürlichen Kräfte bis heute nicht bewiesen und entbehren somit jeglicher wissenschaftlicher Grundlage. Das Interesse der Menschheit über ihre motorischen Fähigkeiten hinaus zu gehen ist allerdings seit hunderten von Jahren ungebrochen. Tatsächlich geben Forschungsergebnisse Anlass zur Vermutung, dass es in absehbarer Zeit möglich sein wird, Dinge durch die Kraft der Gedanken zu bewegen.

Die Erweiterung angeborener Möglichkeiten mittels Technologie hat im medizinischen Bereich erstaunliche Resultate hervorgebracht. So können Querschnittsgelähmte ihre Gedanken formulieren, indem sie per Eye Tracking Botschaften formulieren. Diese Technologie, die ursprünglich in der Werbung eingesetzt wurde, um der Kunden Kaufverlangen zu analysieren, verhilft dazu, dass Betroffene mit Blicken schreiben können. Die Ars Electronica hat nun in einer kollektiven Anstrengung den Menschheitstraum, Dinge durch die Kraft der Gedanken oder Blicken zu bewegen, in einem Projekt umgesetzt, das die Besucher des Ars Electronica Festivals nicht nur bestaunen dürfen. Sie selbst sind aufgefordert einen Schaufelbagger durch Augenbewegung oder Gehirnpower zu kontrollieren. Dass dieses Unterfangen in keiner Weise Hokus Pokus ist, sondern auf der Basis wissenschaftlich fundierter Erkenntnisse beruht, wird durch die Zusammenarbeit von vier Bereichen der Ars Electronica Futurelab, Solutions, Festival und Museum unterstrichen, wie Erika Mondria als Leiterin des Brainlab im Ars Electronica Center und Forscherin unterstreicht. Ebenfalls am Interviewtisch sitzend, nimmt Ali Nikrang als Senior Researcher & Artist des Ars Electronica Futurelab an dem Gespräch teil.

Die Russin Nina Kulagina, die allein durch gedankliche und körperliche Konzentration Dinge bewegen konnte, Kompass-Nadeln drehen ließ, ja sogar Tischtennisbälle schweben lassen konnte. Source: You Toube

Erika: Das gesamte Unterfangen ist als Experiment gedacht, Prototypen auf der Basis zweier Technologien zu entwickeln um einen Bagger einmal mittels Blickkontakt und zum zweiten durch Konzentrationsleistung anzusteuern. Das heißt durch „Eye Tracking“, die Technologie, die während der gesamten Tageszeit am Ars Electronica Festival zum Einsatz kommt, und anderenfalls durch ein Brain Computer Interface, das zu Highlightterminen gefeatured wird. Eye Tracking ist verkürzt gesagt eine Blickanalyse-Hardware, die die Augenbewegung anhand der Pupillenwanderung festmachen kann. Dort wo ich hin fokussiere, kann ich mit dem Blick einen Knopf drücken. Und das funktioniert schon im medizinischen Bereich… auch das Brain Computerinterface. Ich persönlich kenne eine Komapatientin aus Sizilien, die sich dank dieser Technologie nach zehn Jahren zum ersten Mal wieder mitteilen konnte. Die Firme g.-tec medical engineering GmbH aus Oberösterreich, die uns mit Software und Hardware ausstattet und zu denen ich sehr lange Kontakt pflege, hatte ein System entwickelt, das ganz schnell erkennen ließ, ob es sich bei Gedanken um ein „Ja“ oder „Nein“ handelt. Mit dieser technologischen Neuerung konnte sie ihrer Tochter mitteilen, dass sie deren Anwesenheit immer spürte, hörte und auch verstand.

Das erste Brain Computer Interface, das von der g.-tec medical engineering GmbH für PatientInnen entwickelt wurde, wird 2009 vorgestellt.

Wie haben die einzelnen Abteilungen der Ars Electronica nun dieses Projekt mit dem Bagger an den Start gebracht? Welche Expertise brauchte es?

Erika: Das Festival liefert uns den experimentellen Raum – und damit meine ich die logistische als auch die publikumswirksame Unterstützung. Das Futurelab steht natürlich für die langjährige Erfahrung im Bereich des Programmierens, des Forschens und den Mut, den es braucht ein solches Projekt auf die Beine zu stellen. Solutions werfen das Know-How der marktgerechten Kommunikation in die Waagschale. Es braucht die Kontakte und die Fähigkeit Partner zu finden, die bereit sind bei einem solch gewagten Unterfangen mitzumachen. Wir sind froh, dass die Linzer Firma Wacker Neuson einen Bagger, der von der Solutions technisch modifiziert werden muss, so dass er ansteuerbar wird, zur Verfügung stellt. Und last but not least kommt durch meine Arbeit beim Museum die Erfahrung mit Menschen, und die soziale Intelligenz mit ins Spiel, die es braucht um BesucherInnen dazu zu animieren mitzumachen und sie aufzuklären was bei einem solchen Experiment geschieht. Das bedeutet Ihnen die Hemmschwelle zu nehmen, sie ordentlich zu briefen und dafür zu sorgen, dass es von der menschlichen Seite aus läuft. Denn eines muss man wissen: wenn der Mensch auf das Projekt nicht richtig eingestellt ist, dann funktioniert der ganze Apparat nicht.

2003 entwickelten Zach Lieberman, James Powderly, Evan Roth, Chris Sugure und Theo Watson “EyeWriter”, eine erschwingliche Eye-Tracking Software, die es möglich macht auf einem Bildschirm zu malen, indem man die Augen bewegt. Credit: Zach Lieberman, James Powderly, Tony Quan, Evan Roth, Chris Sugrue, Theo Watson

Und wie funktioniert diese Technologie nun genau? Wie kommt die Information vom Gehirn zum Gerät?

Erika: Das Gerät übersetzt nicht 1:1 Deine Gedanken. Im Sinne der Sprachrekonstruktion funktioniert das schon so, aber dafür bedarf es der direkten „Verkabelung“ der Neuronen Deines Gehirns – und das passiert tatsächlich bei medizinischen Fällen. Durch die unterschiedlichen elektrischen Ausschläge die beim Denken erzeugt werden, können die Impulse aufgezeichnet werden. Solche Spannungsunterschiede sieht man als Graph auf einem Computerbildschirm und diese können mittels einer Software als Informationen, wie Sprache, ausgelesen werden. Im experimentellen Bereich wird tatsächlich die Schädeldecke geöffnet und feine, dünne Nadeldn durch die Kopfhaut auf die entscheidenden Stellen gesetzt, von wo aus die Informationen aufgenommen werden. Christoph Guger, der Gründer von g.tec, hat sich vor fünf Jahren gedacht, dass dies erst in 20-30 Jahren möglich sein wird. Daran sieht man die rasante Entwicklung dieser noch jungen Technologie.

Das Projekt am Festival ist ein Blick in die Zukunft, wir verkabeln nicht die Gehirne der BesucherInnen auf die eben geschilderte Art und Weise… es gibt 8 Stellen, die wir auf der Kopfhaut und messen die so genannte „P300“-Welle. Dieses Potenzial taucht nach 300 Millisekunden auf wenn sich beim Menschen der A-ha Effekt einstellt nachdem er etwas erkannt hat, dessen Eintreffen er erwartet hat.

Mittels hochmodernen BCI-Technologien und Methoden des Eye-Tracking können BesucherInnen, egal welchen Alters, den Kettenbagger ET 65 ansteuern und seinen 7 Meter langen Baggerarm bewegen. Credit: Wacker Neuson Linz GmbH

Ali: Stell Dir einfach ein Fußballstadium in überdimensioniertem Ausmaß vor. Da drin gibt es 100.000ende von Menschen, die Geräusche machen – das entspricht ca. 100 Milliarden Neuronen im Gehirn. Wie haben nun 8 Mikrofone aufgestellt um unterschiedliche Informationen aus den Äußerungen der StadionbesucherInnen herauszufiltern, was natürlich schwierig ist, weil die nicht zuordenbaren Geräusche jene überlagern, die man verstehen will. Selbstverständlich kann man mit dieser geringen Zahl Mikrophone nicht herausbekommen was jede/r einzelne sagt, aber wir können anhand des Jubels herausbekommen, wenn ein Tor gefallen ist. Und nach einer Zeit des Zuhörens können wir auch sagen auf welcher Seite dieses Tor gefallen ist. Die 8 Mikofone entsprechen 8 Sensoren, die wir am Kopf befestigen und die verschiedene Steuerbefehle übertragen sollen. Die Befehle, die den Bagger triggern sollen, erfolgen durch die Konzentration der ProbandInnen auf bestimmte Reizauslöser. Ist die Konzentration gestört, dann wird auch kein Befehl ausgelöst… diese Störungen sind die in der Analogie genannten Störgeräusche, die von den StadionbesucherInnen verursacht werden, bzw. aufs Gehirn übertragen, jene Neuronen deren Information man gar nicht braucht. Es ist also ein diffiziles Unterfangen. Würden wir mehr Mikrofone verwenden, bzw. würden wir besser verkabeln, hätten wir genauere Informationen… aber das ist bei dem Baggerprojekt, bei dem es um acht Befehle geht nicht unbedingt notwendig. Im Training lernen die BesucherInnen des Festivals die Befehle und auf was sie sich konzentrieren müssen um diese auszuführen. Das befähigt – uns wie bei einer Art blindem Stadionbesucher – ausfindig zu machen, ob der Jubel nach Torschuss auf der rechten, bzw. linken Seite stattgefunden hat und können Rückschlüsse auf die Funktionalität bzw. das Konzentrationsvermögen des oder derjenigen Teilnehmerin ziehen, die gewillt ist den Bagger zu bewegen.

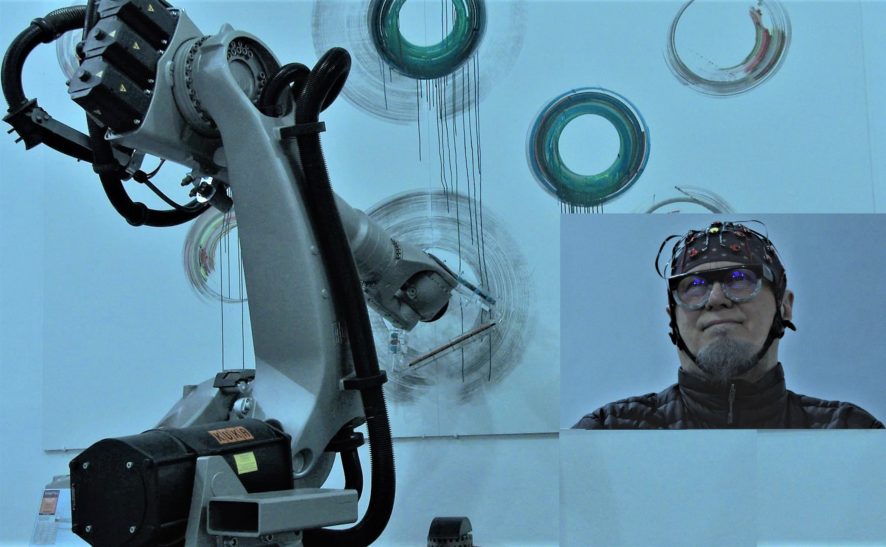

Dragan Ilić benutzt ein elaboriertes Brain-Computer-Interface (BCI) system mit dessen Hilfe er einen Hi-Tech Roboter mittels Gehirn und State-Of-The Art Technologie steuert. Credit: A3 K3 Intermedia/Trans-technological performance & interactive installation by Dragan Ilic. Courtesy of the artist & GV Art London.

Was kann denn auf der menschlichen Seite schief gehen? Man kann sich ja vorstellen, dass wenn die Leute eine solche Kappe aufbekommen und verkabelt werden, sich wie ein Laborkaninchen fühlen?

Erika: Die 8 Mikrophone, die Ali als Beispiel genannt hat entsprechen nur 8 Elektroden und diese haben die Aufgabe den Jubel der Zuschauer, bzw. das Potenzial 300 zu messen. Da wir ständig mit den Gedanken abgelenkt sind, entspricht dies dem überlagerten Signal, das schwierig sein wird genau zu lokalisieren. Aber das kann unser Gerät! Da kann man sich vorstellen was es für eine Leistung ist etwas zu messen, das sich nur in Mikrovoltbereich abspielt. Diese riesige Datenmenge muss entlang der Kabellänge oder bereits schon schnurlos weitergeleitet und digitalisiert werden. Ein Computermodell entschlüsselt dann diese riesige Datenmenge und errechnet eine Differenz in Millisekunden. DAS ist die Leistung dieser Technologie.

Inwiefern musste nun die gängige Software umprogrammiert werden damit sie auf dieses Projekt genau passt?

Ali: Ich muss der Software beibringen, dass sie auf die spezifische Anforderung hin verstehen kann was sie auslösen muss damit sich zum Beispiel der Schaufelarm in Bewegung setzt. Man kann es sich wie eine Matrix mit Symbolen vorstellen. Indem der Mensch beim Auftauchen von verschiedenen Symbolen gedanklich reagiert, löst er den Befehl aus. Aber die Übersetzung muss so funktionieren, dass die Maschine den Befehl aufnehmen, bzw. dechiffrieren kann. Das ist wie Wertezuordnungen, die digitalisiert werden und am anderen Ende so rauskommen, dass eine Technologie sie lesen kann, die dann quasi das Baggerkommando per elektrischem Impuls gibt. So würde ich das einem Laien kurz erklären.

Das Spannende an dem Projekt ist, dass wir zwei Welten zusammenbringen, die auf den ersten Blick nicht zueinander passen. Auf der einen Seite haben wir das präziseste Gerät der Welt, das im Mikrovoltbereich arbeitet, nämlich das menschliche Gehirn, auf der anderen Seite eine rechte grobe Motorik, die dazu konstruiert wurde per Kraftausübung Dinge umzuwälzen. Das Künstlerische in diesem Projekt ist das Aufeinanderprallen zweier Welten, die weiter entfernt voneinander nicht sein könnten.

Seit 2009 leitet Erika Mondria das Brainlab am Ars Electronica Center und sorgt indessen ständig für neue Kooperationen und Programme für die Besucher und Besucherinnen um das immerwährend im Wechsel begriffene Feld der Neurowissenschaften und Brain Computer Interfaces begreifbar zu machen. Sie studierte an der Linzer Kunstuniversität und der Johannes Keppler Universität Kunst- und Kulturwissenschaften, Kunst sowohl am London Institute Camberwell College & Central St. Martins College als auch in Marsaille an der Aix Marsaille Université.

Seit 2009 leitet Erika Mondria das Brainlab am Ars Electronica Center und sorgt indessen ständig für neue Kooperationen und Programme für die Besucher und Besucherinnen um das immerwährend im Wechsel begriffene Feld der Neurowissenschaften und Brain Computer Interfaces begreifbar zu machen. Sie studierte an der Linzer Kunstuniversität und der Johannes Keppler Universität Kunst- und Kulturwissenschaften, Kunst sowohl am London Institute Camberwell College & Central St. Martins College als auch in Marsaille an der Aix Marsaille Université.

Ali Nikrang ist Senior Researcher & Artist im Ars Electronica Futurelab wo er Mitglied der Forschungsgruppe Virtual Environments ist. Einer der Schwerpunkte in seiner Arbeit ist die Kluft zwischen der realen und der virtuellen Welt durch Entwicklung neuer Methoden zu verringern, so dass die Benutzer sich mehr und mehr wie in einer realen Welt fühlen. Er beschäftigt sich zudem auch mit der Entwicklung von computergestützten Modellen zur Simulation der menschlichen Empfindungen, die bei der akustischen oder visuellen Wahrnehmung eines Kunstwerkes entstehen.

Ali Nikrang ist Senior Researcher & Artist im Ars Electronica Futurelab wo er Mitglied der Forschungsgruppe Virtual Environments ist. Einer der Schwerpunkte in seiner Arbeit ist die Kluft zwischen der realen und der virtuellen Welt durch Entwicklung neuer Methoden zu verringern, so dass die Benutzer sich mehr und mehr wie in einer realen Welt fühlen. Er beschäftigt sich zudem auch mit der Entwicklung von computergestützten Modellen zur Simulation der menschlichen Empfindungen, die bei der akustischen oder visuellen Wahrnehmung eines Kunstwerkes entstehen.