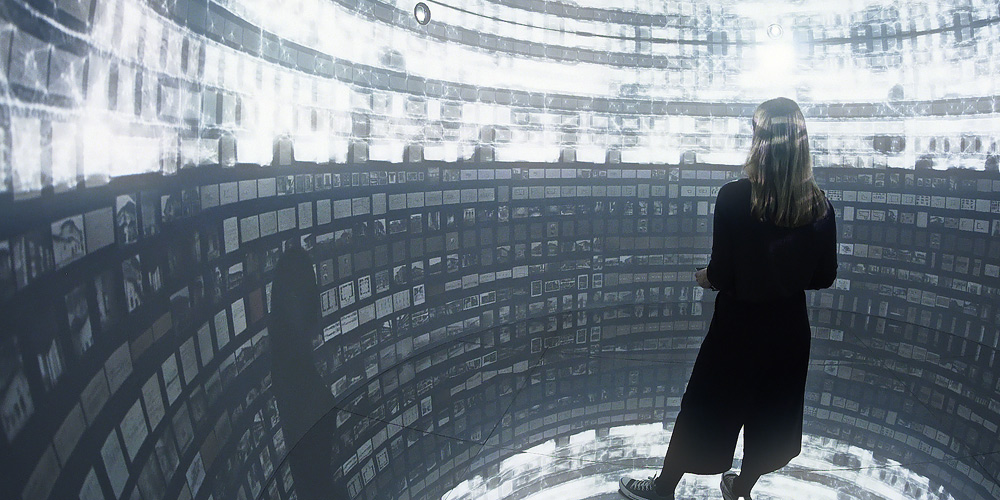

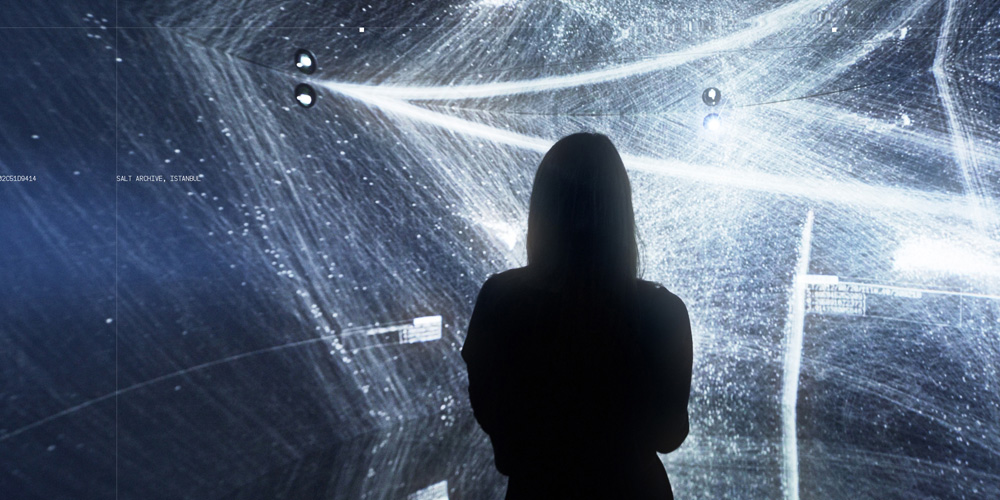

Credit: Refik Anadol

Diese Ausstellung bietet einen umfassenden Überblick über aktuelle künstlerische Arbeiten, die maschinelles Lernen und AI verwenden. Ergänzt wird sie durch ein Seminar-Programm von und für KünstlerInnen, in denen man sich das Rüstzeug aneignen dafür kann, um bei künstlerischen Projekt selbst mit maschinellem Lernen zu arbeiten.

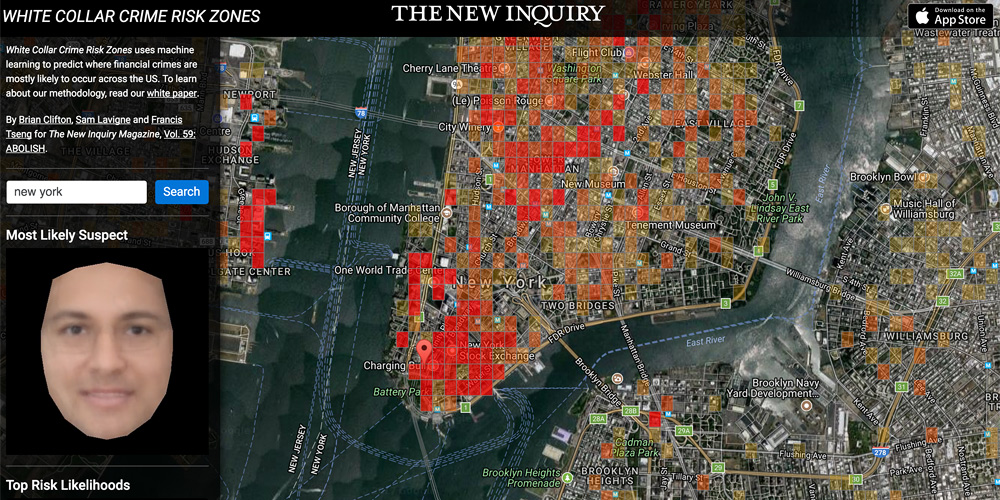

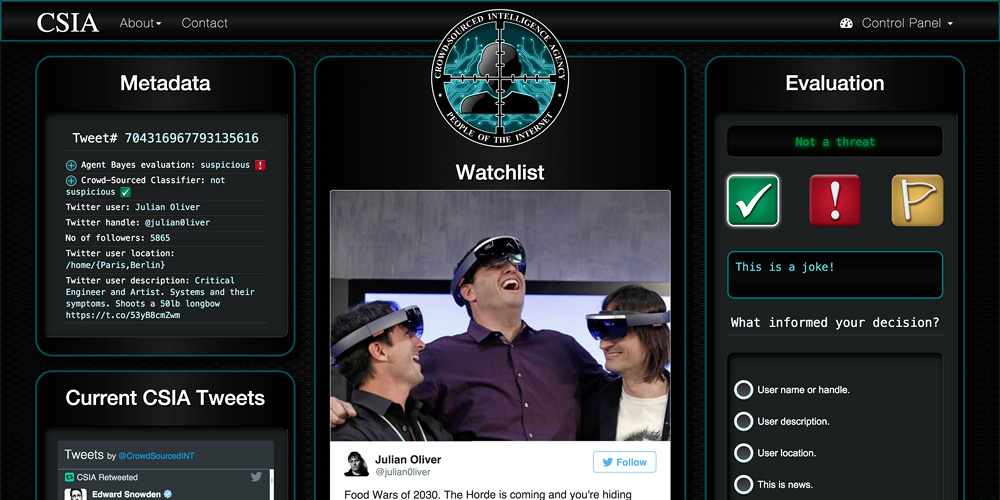

Die „CSIA“ ist ein kreatives Forschungsprojekt, das das System einer Open-Source Intelligenz nachbildet. Ein Interface ermöglicht es BenutzerInnen zu erfahren, wie Geheimdienste Social Media-Beiträge überwachen. Außerdem beinhaltet die Arbeit zwei maschinell lernende Klassifikatoren für vorausschauende Polizeiarbeit.

Man sagt, jeder Mensch auf der Welt sei über wenige andere miteinander vernetzt. Ist dies auch der Fall bei Kunstwerken? X Degrees of Separation macht sich auf die Suche nach Gemeinsamkeiten unterschiedlicher Artefakte. Mithilfe von maschinellen Lernverfahren werden visuelle Merkmale analysiert und durch eine Kette von anderen Kunstwerken miteinander verknüpft.

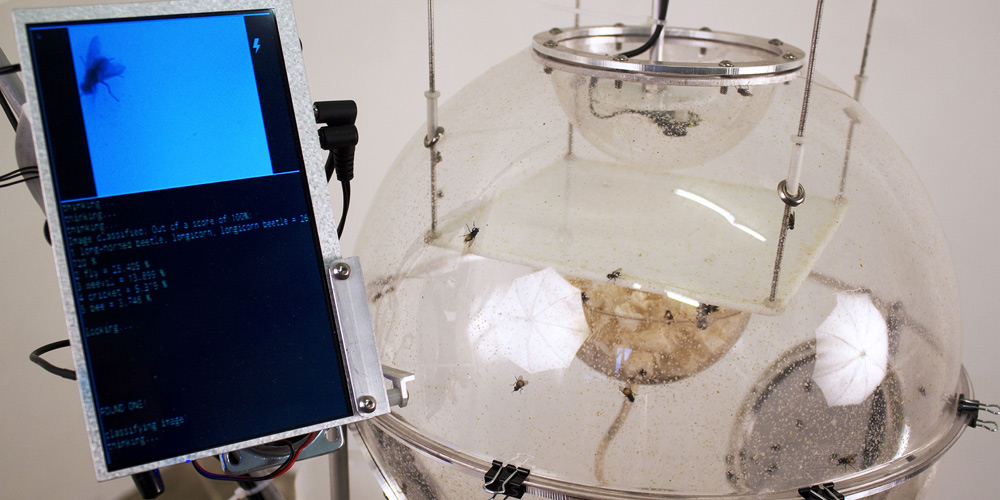

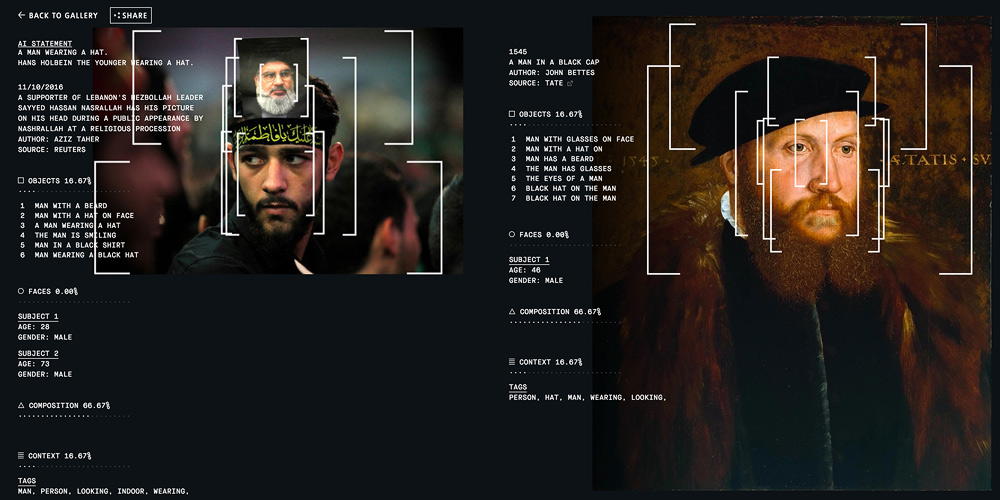

Kann eine Maschine uns dazu bringen, Kunst aus dem Blickwinkel unserer heutigen Welt zu betrachten? Inspiriert durch den Widerspruch bringt Recognition eine künstliche Intelligenz ins Museum – in den Kontext eines so subjektives Feldes wie Kunst und konfrontiert dieses mit rationalem, objektivem Denken.

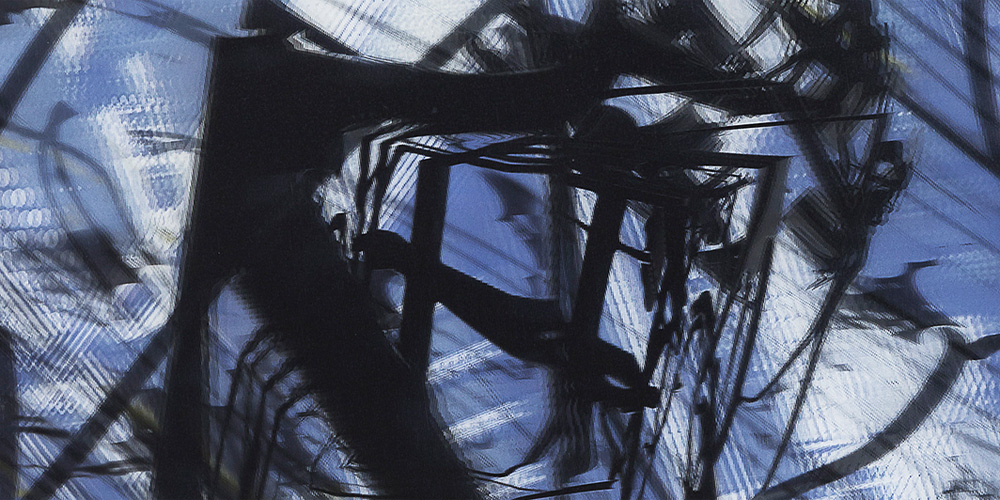

Fall of the House of Usher basiert auf der gleichnamigen Kurzgeschichte von Edgar Allen Poe. In der zwölf Minuten dauernden Animation wird jedes Bild mithilfe von künstlicher Intelligenz erzeugt: Die Künstlerin fertigte Tuschezeichnungen von Bildern des Originalfilms aus dem Jahr 1929 an. Ein neuronales Netzwerk (pix2pix) wurde anhand dieser Zeichnungen trainiert.

Basierend auf AI-Modellen, die derzeit unter anderem in der Moderation und Überwachung von digitalen Inhalten eingesetzt werden, erforscht die Installation den “latenten Raum” der künstlichen Intelligenz. Sie verarbeitet und imaginiert eine eigene Welt und entwickelt Träume und Visionen in den verborgenen Zwischenräumen zwischen all dem, was sie von uns gelernt hat, und weit darüber hinaus.

Der Film Blade Runner – Autoencoded entstand, indem man einen Autoencoder, also ein spezielles neuronales Netzwerk, trainierte, um Einzelbilder aus dem Film Blade Runner aus dem Jahr 1982 nachzubilden. Der Autoencoder lernt, alle Einzelbilder zu modellieren, indem er versucht, sie durch einen Informations-Engpass zu kopieren.

Der Haustier-Roboter AIBO wurde 1999 als weltweit erster Home-Entertainment-Roboter geboren. Sony baute rund 150.000 Roboter, bevor die Produktion und der Verkauf im Jahr 2006 eingestellt wurden. 2014 beendet das Unternehmen auch den technischen Support. Da viele EigentümerInnen nach wie vor sehr an ihrem AIBO hängen, reparieren und warten ehemalige Sony-Ingenieure die Roboter für sie.

Vor allem durch den Einsatz digitaler Technologien ist unsere permanente Präsenz, unsere Kommunikationsbereitschaft und unsere Fähigkeit zur Informationsaufnahme gefragt. Ausgehend von dieser Situation erschafft Emanuel Gollob ein fiktives Szenario: Studienergebnisse zeigen, dass die Effizienz unserer Gesellschaft durch Nichtstun gesteigert wird.

Landmarks besteht aus einer Serie von 3D-Lentikularbildern. Körperhafte Gebilde in Form von Liniengeflechten und Flächenformationen scheinen sich von der Bildfläche abzuheben und im Raum vor der eigentlichen Bildebene zu schweben. Diese fluktuierenden Gebilde entstehen auf der Basis von virtuellen Drahtgittermodellen.

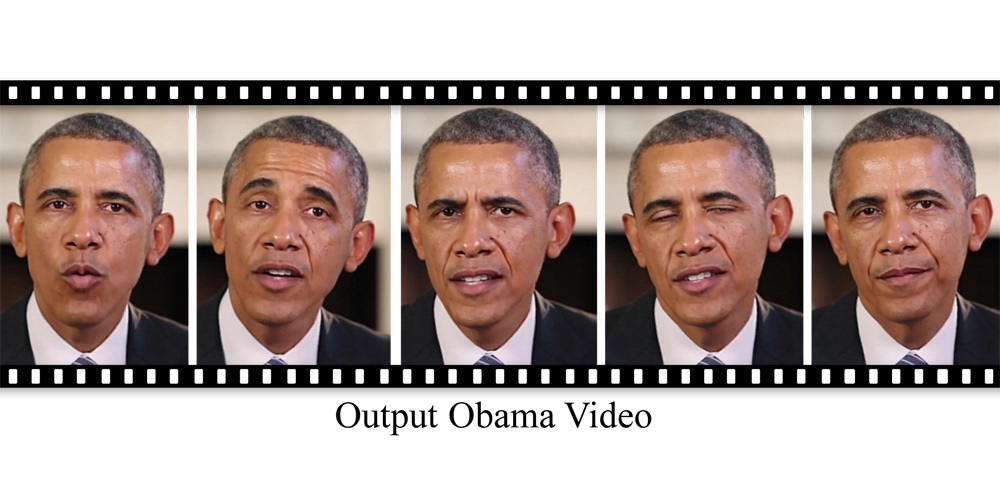

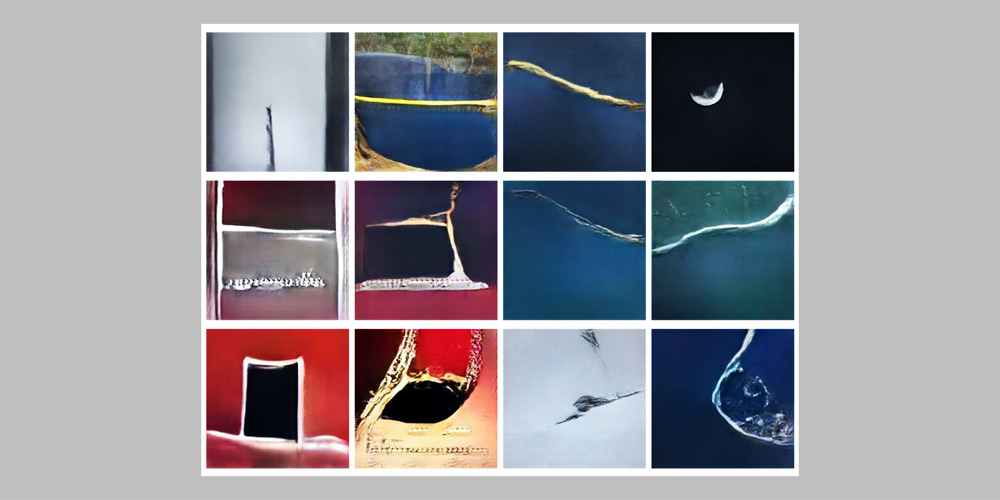

Ein dichtes neuronales Netzwerk, das seine Augen zum ersten Mal öffnet und versucht zu verstehen, was es sieht. Learning to See ist eine noch nicht abgeschlossene Serie von Arbeiten, die hochmoderne Algorithmen aus dem Bereich des maschinellen Lernens nutzen, um über uns selbst und darüber, wie wir die Welt interpretieren, zu reflektieren.